Numerische Wettervorhersage

Almut Gaßmann

Wie wird das Wetter morgen? Um diese ewige Frage zu beantworten, nutzt man schon seit Jahrzehnten Computer. Das Prognoseverfahren ist aufwendig: Messdaten von Wind, Temperatur und anderen Größen weltweit gehen in die Vorhersage mit ein. Die umfangreiche Software der Wetterprognosemodelle beruht auf den Grundgesetzen der Physik. So berechnen Meteorologen mit ihren Supercomputern das Wetter der nächsten Tage.

Im Prinzip geht die Vorhersage auf die Erhaltungssätze der Physik zurück: Die Energie, der Impuls sowie die Masse von Luft und Wasser bleiben in geschlossenen Systemen in der Zeit konstant. Diese physikalischen Gesetze bilden die Basis für die Gleichungen der Wettermodelle. Mathematisch gesprochen handelt es sich dabei um partielle Differentialgleichungen in Raum und Zeit. Berechnet wird mit den Gleichungen nicht nur, wie sich in der Atmosphäre die Temperatur, die Feuchte, der Druck, der Horizontalwind und die vertikale Windkomponente verändern. Auch die obersten Schichten des Erdbodens müssen einkalkuliert werden – hier genügt es, sich auf die Temperatur und die Feuchte zu beschränken.

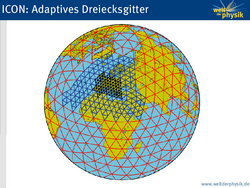

Diskretisierung

Es wäre sehr praktisch, wenn die Lösungen der Modellgleichungen analytisch gefunden werden könnten, also durch Umrechnen der Formeln, sodass schließlich eine Gleichung wie „Temperatur am Donnerstag = Temperatur am Mittwoch + Luftdruck zum Quadrat mal X“ herauskommen würde. Doch das ist mathematisch unmöglich. Darum machen die Meteorologen von einem Verfahren Gebrauch, das sich Diskretisierung nennt: Sie „zerschneiden“ die Lufthülle horizontal und vertikal, sodass handliche Einzelteile entstehen. Anhand eines mathematischen Gitternetzes definieren sie so tausende virtueller Kästen. Was in den Computermodellen berechnet wird, ist dann die zeitliche Veränderung der durchschnittlichen Wetter-Kenngrößen in diesen Kästen. Das regionale Wettervorhersagemodell COSMO-DE des Deutschen Wetterdiensts besitzt zum Beispiel 50 vertikale Schichten, deren Dicke von 10 Metern am Boden bis zu mehreren Kilometern in der Stratosphäre zunimmt. Der horizontale Gitternetzabstand beträgt 2,8 Kilometer. Auch die Zeit wird diskretisiert: Ein Rechenschritt entspricht einem Zeitintervall von 25 Sekunden. Im Jahr 2016 soll auf das neue Modell COSMO-D2 umgestellt werden. Damit wird sich der horizontale Gitternetzabstand auf 2,2 Kilometer verringern und die Zahl der vertikalen Schichten auf 65 erhöhen.

Parametrisierung

Doch nicht alle Vorgänge des Wetters können in einem Computermodell wirklichkeitsgetreu dargestellt werden. Probleme bereiten jene Vorgänge, die in der Größenordnung des Gitterabstands ablaufen oder noch kleiner sind – also quasi durch die Maschen des Gitters fallen. Eine Gewitterwolke zum Beispiel mag am Himmel riesig erscheinen. Für das Wettermodell ist sie aber in der Regel zu klein. Aus diesem Grund „parametrisieren“ die Fachleute solche Prozesse: Was sie nicht direkt berechnen können, drücken sie mit Hilfe der anderen Variablen aus. Das ist eine Wissenschaft für sich, die bei der Prognose viel Rechenzeit beansprucht. Neben den konvektiven Wolken wie den Gewitterwolken, werden auch Schichtwolken, die Turbulenz und die kurzwelligen und langwelligen Strahlungsprozesse parametrisiert. Nicht zu vergessen sind die Wärme- und Feuchteflüsse am Boden, die zusätzlich ein eigenes Modell für die Bodenschichten erfordern.

Assimilation

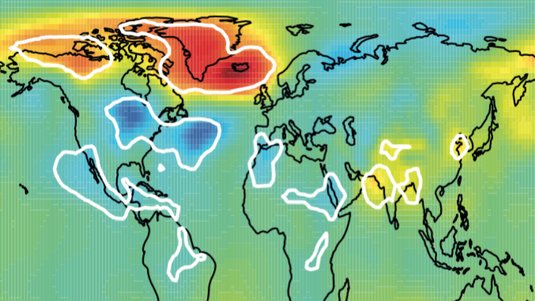

Um die Entwicklung des Wetters zu berechnen, müssen die Computermodelle natürlich von irgendeinem Anfangszustand ausgehen. Dazu benötigt man die gemessenen Wetterdaten. Sie werden an den Wetterstationen der nationalen Wetterdienste aufgezeichnet, aber auch von Satelliten, mit Radargeräten, von Bojen, Wetterballonen und von Flugzeugen beim Start und bei der Landung. Weltweit sind tausende von Stationen an den regelmäßigen Messungen des Wetters beteiligt. Man kann allerdings nicht einfach die gemessenen Wetterdaten nehmen und losrechnen. Häufig fehlen an irgendwelchen Stellen ein paar Daten. Außerdem befinden sich die Messstationen nicht unbedingt im Mittelpunkt der virtuellen Modellkästen, sondern oft auch am Rand. Und es ist für die Modellrechnungen unbedingt erforderlich, dass die Wetterdaten physikalisch genau zueinander passen. Sonst geschehen im Computermodell ganz merkwürdige, unrealistische Dinge – virtuelle atmosphärische Schwingungen bilden sich und dann regnet es an den falschen Stellen.

Um einen möglichst korrekten Anfangszustand für die Prognoserechnung zu ermitteln, haben sich Meteorologen darum sogenannte Assimilationsverfahren ausgedacht. Dabei fängt man mit der letzten Vorhersage des Computermodells an und versucht, das Modell zu den gemessenen Daten „hinzuziehen“. Diese sehr langwierige Rechnerei erfordert ähnlichen Aufwand wie die Prognose selbst. Es überrascht darum sicher nicht, dass die größten nicht militärisch genutzten Rechner der Welt für Wetter- und Klimasimulationen verwendet werden. So weist zum Beispiel der Computer des Deutschen Wetterdiensts (DWD) eine theoretische Maximal-Rechenleistung von 560 Teraflops auf (Stand September 2015) – das sind 560 Billionen Gleitkommaoperationen pro Sekunde. Mit dem Modell COSMO-DE wird das Wetter achtmal am Tag 27 Stunden im Voraus berechnet. Wie wichtig genaue Anfangsbedingungen sein können, sah man bei der Prognose des Orkans Lothar, der am 26. Dezember 1999 in Deutschland große Schäden anrichtete. Weil zwei Tage zuvor von einem Wetterballon nahe Nova Scotia (Kanada) fehlerhafte Daten übermittelt wurden, konnte die heftige Entwicklung des Orkantiefs zunächst nicht vorhergesehen werden. Erst spätere Simulationsläufe zeigten die Gefahr, die von Lothar ausging, deutlich.

Randbedingungen

Neben den Anfangsbedingungen braucht jedes Wettermodell auch noch sogenannte Randbedingungen – das sind nicht bloß die Wetterbedingungen am Rande eines Ausschnittsmodell (wie dem COSMO-DE), sondern auch wichtige, sich nur langsam ändernde Größen wie die Temperatur an der Meeresoberfläche oder die Meereisbedeckung. Während die Bedingungen am Rand anhand globaler Wetterprognosemodelle bereitgestellt werden, lassen sich die Temperatur und die Eisbedeckung des Meeres mit Satelliten messen. Sie gehen als Konstanten in die Berechnung ein.

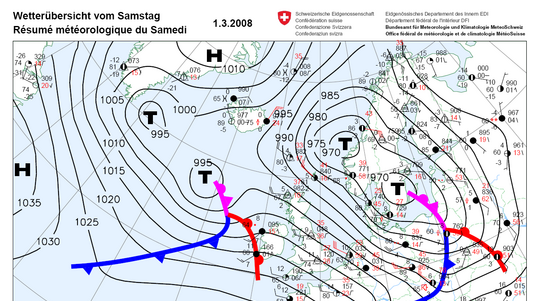

Nachbereitung

Wenn die numerische Prognose der Computer vorliegt, ist die Arbeit der Meteorologen noch längst nicht zu Ende. Denn dann geht die Nachbereitung los (das sogenannte Postprocessing): Aus den digitalen Daten werden zunächst einmal automatisch zahlreiche Wetterkarten und andere Visualisierungen erstellt. Um seinem gesetzlichen Auftrag der Daseinsvorsorge nachzukommen, werden vom DWD aus den Prognosen Warnhinweise erarbeitet, zum Beispiel für Technisches Hilfswerk, Feuerwehr und viele Behörden. Selbstverständlich beziehen die Medien und private Wetterdienste sowohl Daten als auch Basisvorhersagetexte vom DWD. Landwirte und Forstwirte erwarten wieder andere spezielle Vorhersageinformationen.

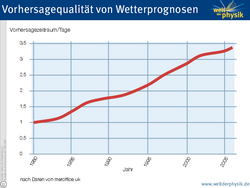

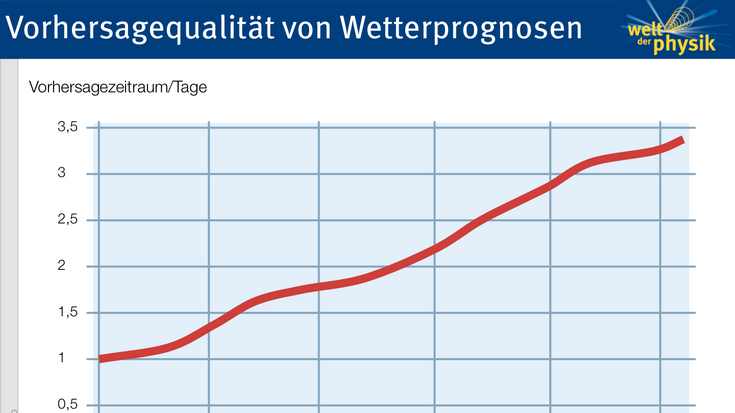

Vorhersagequalität

Schließlich werden die Wetterprognosen tagtäglich geprüft – nicht nur von den Menschen im Land, sondern auch von den Mitarbeitern des DWD. Die Verbesserung der Vorhersagen ist deutlich erkennbar: Heutzutage ist eine Prognose der Lufttemperatur über drei Tage verlässlicher als vor 25 Jahren eine Prognose für den nächsten Tag. Am schwierigsten bleibt es allerdings, Regen und Schnee vorherzusagen. Doch auch dabei gibt es immer mehr Fortschritte. Je feiner die numerischen Wettermodelle aufgelöst sind, desto besser können die komplizierten Prozesse, die etwa einen sommerlichen Regenguss auslösen, berechnet werden.

Welt der Physik/MPI für Meteorologie

Quelle: https://www.weltderphysik.de/gebiet/erde/atmosphaere/wetter/wettervorhersage/