Das Problem mit der Feinjustierung

Das Standardmodell ist wohl die umfassendste Theorie, die es jemals gab. Dennoch sehen Teilchenphysiker damit das Ende der Physik noch längst nicht erreicht und suchen eifrig nach neuen Theorien. Dabei motivieren sie nicht etwa irgendwelche inneren Widersprüchen des Modells oder experimentelle Zwänge, sondern allein die Ästhetik.

Ein Physikprofessor soll Max Planck am Ende des 19. Jahrhunderts dazu geraten haben, nicht Physik zu studieren. Schließlich sei dort, abgesehen von wenigen Lücken, bereits alles erforscht. Heute hätte wohl kein Hochschullehrer mehr solche Bedenken. Dieses vorherrschende Gefühl lässt sich allerdings nur teilweise fachlich begründen. Es ist vor allem mit Problemen der Wissenschafts- und Erkenntnistheorie verbunden.

Obwohl das Standardmodell der Teilchenphysik gegenwärtig wohl die umfassendste Theorie darstellt, kann es einige Phänomene vom Prinzip her nicht beschreiben. Allem voran steht hier die Gravitation. Zudem gibt das Standardmodell keine Antwort auf die Frage nach Dunkler Materie oder Dunkler Energie, auf die astrophysikalische und kosmische Beobachtungen hinweisen. Deshalb sehen die meisten Teilchenphysiker das Standardmodell nur als eine Stufe auf dem Weg zu einer noch umfassenderen und in gewissem Sinne „einfacheren“ oder „schöneren“ Theorie – Begriffe und Ziele, die mehr philosophisch motiviert sind, als aus immanenten Problemen der Wissenschaft zu folgen.

Das Standardmodell wird demnach oft nur als sogenannte effektive Theorie verstanden, die im Bereich niedriger Energien als Grenzfall einer weitreichenderen Theorie fungiert. Dieses Verhalten kennt man bereits aus anderen Teilgebieten der Physik, wie beispielsweise der klassischen Mechanik: Alle physikalischen Phänomene bei Geschwindigkeiten und Abständen des Alltagslebens – also deutlich langsamer als Licht und deutlich größer als ein Atom – werden durch diese Theorie völlig adäquat beschrieben. Heute versteht man die klassische Mechanik aber als Grenzfall der Relativitätstheorie beziehungsweise der Quantenmechanik.

Vom Standardmodell wissen wir nur, dass es bei Abständen von mindestens einem Milliardstel des Atomdurchmessers gilt. Genauer können die heutigen Beschleuniger nicht auflösen. Für Elementarteilchen wird die Gravitation aber erst bei Abständen relevant, die noch etwa eine billiardemal kleiner sind. Die Sensitivität von Teilchenbeschleunigern wird wohl nie auch nur in die Nähe dieser sogenannten Plancklänge vordringen. Allerdings legt die Struktur des Standardmodells nahe, dass man bereits bei deutlich größeren Abständen Hinweise auf eine übergeordnete Theorie finden sollte.

Keine einfache Theorie

Zwar beruht das Standardmodell im Wesentlichen auf wenigen Prinzipien – vor allem der Eichsymmetrie –, aber dennoch sind 27 Parameter notwendig, die nicht a priori durch die Theorie festgelegte Werte besitzen und durch Messungen bestimmt werden müssen. Diese Zahl erscheint einerseits zu groß, um von einer „schönen“ und „einfachen“ Theorie zu sprechen. Andererseits zeigen einige der Parameter gewisse Regelmäßigkeiten oder Hierarchien, die alles andere als zufällig wirken, deren Ursachen man aber derzeit nicht kennt.

Ein Beispiel: Es existieren zwölf Materieteilchen, die sich in drei fast identische Familien einordnen lassen. Warum existieren diese Wiederholungen? Hauptsächlich unterscheiden sich die Familien durch die Massen der zugehörigen Teilchen. Das Topquark ist beispielsweise mehr als eine Trillion Mal schwerer als das leichteste Neutrino. Welche Ursache hat dieses gewaltige Massenspektrum? Der Higgs-Mechanismus „erzeugt“ zwar Massen, leistet für diese Strukturen aber keinerlei Erklärungen.

Diese und noch andere Eigenschaften des Standardmodells weisen darauf hin, dass es eine neue, umfassendere Theorie geben sollte. Die Suche nach dieser neuen Theorie beruht weitgehend auf Prinzipien wie Einfachheit, Schönheit oder Natürlichkeit. Einer der wichtigsten Ansatzpunkte ist hier natürlich der Higgs-Mechanismus. Von vielen Physikern wird dieser nur als Hilfskonstruktion gesehen, der unter Umständen auf einen tiefer liegenden Mechanismus hindeutet. Denn auch hier finden sich noch einige Schönheitsfehler.

Laut der Theorie wäre das Higgs-Boson das einzige fundamentale Teilchen ohne Eigendrehimpuls. Was erst einmal wie eine kleine Randnotiz aussieht, erweist sich als gravierendes theoretisches Problem. Aus der Wechselwirkung mit den allgegenwärtigen quantenmechanischen Fluktuationen des Vakuums – hier entstehen und verschwinden laufend kurzlebige Teilchen-Antiteilchen-Paare – erhält jedes Teilchen einen Beitrag zu seiner Masse. Die Differenz zwischen dieser „Strahlungsmasse“ und der im Experiment beobachteten physikalischen Masse des Teilchens ergibt die „nackte Masse“. Letztere beschreibt also die Masse, die das Teilchen hypothetisch hätte, wenn es keine Vakuumfluktuationen gäbe.

Unter bestimmten Annahmen lässt sich die Strahlungsmasse für jedes Teilchen berechnen. Bei Teilchen mit einem Spin größer als Null, wie etwa Elektronen und Quarks, fällt die Strahlungsmasse klein aus. Die nackte Masse entspricht damit ungefähr der physikalischen Masse. Anders beim Higgs-Teilchen: Hier hängt die Strahlungsmasse vom Quadrat der höchsten Energie ab, an der das Standardmodell noch Gültigkeit besitzt. Sollte das Standardmodell tatsächlich bis zu Abständen von der Größenordnung der Plancklänge gelten, wäre die Strahlungsmasse hundert Billionen Mal größer als die physikalische Masse des neu entdeckten Teilchens von etwa 125 Gigaelektronenvolt. Es sieht also so aus, als ob die nackte Masse und die Strahlungsmasse fast exakt entgegengesetzt gleich groß wären und sich über viele Größenordnungen kompensieren.

Von neuen Symmetrien und Unteilchen

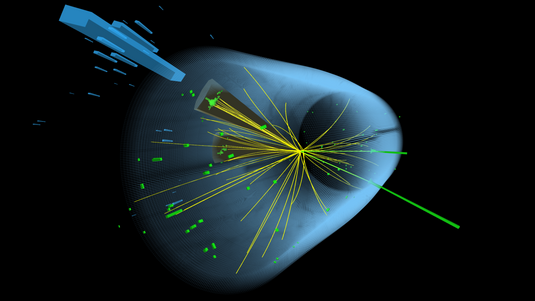

Formal stellt dies zwar kein Problem dar, aber eine solche enorme Feinjustierung schreit förmlich nach einer Erklärung. Schließlich handelt es sich bei nackter und Strahlungsmasse um zwei völlig verschiedene Dinge. Warum sollten sie also über dreißig Größenordnungen denselben Zahlenwert aufweisen? Eine Lösung dieses Feinjustierungsproblems könnte sein, dass das Standardmodell bereits bei relativ niedrigen Energien – beziehungsweise großen Abständen – durch eine übergeordnete Theorie ersetzt wird. In den meisten Fällen resultieren solche Theorien in neuen Teilchen, die dann am LHC entdeckt werden könnten.

Die neuen Theorien sind also weder durch irgendwelche inneren Widersprüche des Standardmodells noch durch experimentelle Zwänge motiviert, sondern allein durch Ästhetik. Das Feinjustierungsproblem war in den vergangenen Jahrzehnten wohl die wichtigste Triebfeder beim sogenannten Model Building – der Suche nach Modellen jenseits des Standardmodells. Oft entstehen dabei geniale, revolutionäre, mitunter vielleicht sogar abstruse Ideen, die neue Symmetrien, zusätzliche Raumdimensionen oder völlig neuartige Objekte wie beispielsweise „Unteilchen“ postulieren, und natürlich alle möglichen Kombinationen davon. Die Entdeckung des neuen Teilchens am LHC und das gleichzeitige Fehlen von Signalen anderer neuer Teilchen bedeutet für viele dieser Ideen allerdings das abrupte und definitive Ende.

Physiker und Philosophen stellen sich gleichermaßen die Frage, ob das schwer quantifizierbare Problem der Feinjustierung (Wie viel Feinjustierung ist erlaubt?) wirklich das Kriterium für neuartige Theorien sein kann, oder ob es sich dabei nur scheinbar um ein Problem handelt. Auch diese Frage verschärft sich vor dem Hintergrund der bisherigen Ergebnisse des LHC.

Bislang gibt es keinen Hinweis darauf, dass eine der vorgeschlagenen neuen Theorien verwirklicht ist. Viele Theorien, die das Feinjustierungsproblem lösen oder umgehen wollen, führen zu Ergebnissen, die im Widerspruch zu Messungen stehen. Dies bewirkt eine hohen Dynamik bei der Entwicklung von Modellen, die oft auf sehr eleganten Ideen beruhen, dann aber sehr unattraktiven Modifikationen unterworfen werden müssen, um im Einklang mit den Messungen zu bleiben. Theorien werden zwar selten verworfen, aber oft irgendwann nur noch von einigen hartgesottenen Anhängern verfolgt.

Sollte das Feinjustierungsproblem allerdings real sein, dürfte es in einem Energiebereich gelöst werden, in den der LHC in den nächsten fünf bis sechs Jahren vordringen soll. Dann lassen sich auch Teilchen aufspüren, die bis zu zehnmal schwerer sind als das im Juni 2012 entdeckte Boson.

Quelle: https://www.weltderphysik.de/gebiet/teilchen/bausteine/jenseits-des-standardmodells/das-standardmodell-umfassend-aber-nicht-genug/feinjustierung/