„Informationsfeldtheorie dort einsetzen, wo sie hilft“

Denise Müller-Dum

South African Radio Astronomy Observatory (SARAO)

Physikalische Experimente erzeugen große Datensätze – und trotzdem sind die gewonnenen Informationen nie vollständig. So messen etwa Teleskope nur bestimmte Eigenschaften des Nachthimmels, aber nicht alle. Um die gemessenen Daten in Bilder zu übersetzen, nutzen Forschende aufwendige Rechenverfahren. Torsten Enßlin vom Max-Planck-Institut für Astrophysik in Garching erzählt im Interview mit Welt der Physik von einer Methode des maschinellen Lernens, die solche Rekonstruktionen von Bildern für verschiedene Fragestellungen einheitlich löst.

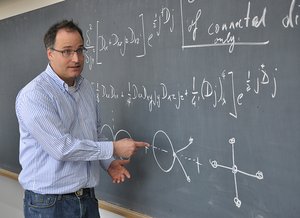

Welt der Physik: Welche Methode nutzen Sie, um Bilder aus Messdaten zu gewinnen?

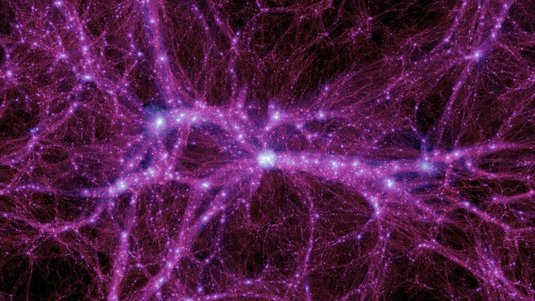

Torsten Enßlin: Um Messdaten in Bilder zu übersetzen, nutzen wir die Informationsfeldtheorie – eine mathematische Methode für den Umgang mit Daten, die ich entwickelt habe. Es geht dabei um sogenannte Felder, also physikalische Größen, die sich messen lassen und im Raum verschiedene Werte annehmen können – beispielsweise die Lufttemperatur über Europa oder die Dichte der Materie im Universum. Man möchte in der Regel ein vollständiges Bild aus den Messdaten gewinnen. Es soll Auskunft über den Wert einer Messgröße, wie etwa der Lufttemperatur, an jedem Punkt im Raum geben – und das, obwohl man nicht jeden einzelnen Wert messen kann. In der Praxis muss man sich dieses Gesamtbild aus sehr lückenhaften Informationen erschließen.

Können Sie das an einem Beispiel erläutern?

Mit astronomischen Teleskopen möchten wir zum Beispiel herausfinden, wie hell der Himmel an verschiedenen Orten und bei verschiedenen Wellenlängen zu verschiedenen Zeitpunkten ist. Solch ein Instrument misst aber nicht all diese Eigenschaften des Himmels auf einmal. Es ist nur für einen bestimmten Wellenlängenbereich ausgelegt, schaut nicht überall hin und misst die Helligkeit nicht zu allen Zeitpunkten. Aus den Messdaten bekommt man also nicht die volle Information, die man braucht, um zu sagen, wie hell der Himmel ist. Das heißt, wir müssen die Leerstellen füllen und das machen wir mit möglichst plausiblen Annahmen.

Wie kommt man zu solchen plausiblen Annahmen?

Dazu braucht man Wahrscheinlichkeitstheorie. Das deutsche Wort Wahrscheinlichkeit sagt ziemlich genau, was darunter zu verstehen ist: Wie wahr scheint etwas zu sein? Wie viel Vertrauen sollte man in die Möglichkeit setzen, dass eine gewisse Aussage stimmt? Wir versuchen dieses Vertrauen mit Zahlen zwischen null und eins zu beziffern. Eins heißt 100 Prozent: Ich bin absolut sicher, dass es so ist. Null heißt: Ich bin absolut sicher, dass es nicht so ist. Und dazwischen gibt es Abstufungen. Als Beispiel können wir uns einen Münzwurf anschauen. Wenn man nämlich eine ideale Münze wirft, dann ist die Wahrscheinlichkeit, dass am Ende die Seite mit der „Zahl“ oben liegt, genau 0,5 – das entspricht 50 Prozent. Die Wahrscheinlichkeitsrechnung sagt, wie man mit solchen Zahlen umgeht und wie man neue Informationen einbezieht.

Wie lässt sich dann mithilfe von Wahrscheinlichkeitsrechnung aus Teleskopaufnahmen ein Bild gewinnen?

Je nachdem, wie man die Lücken – also die fehlenden Messdaten – füllt, gibt es eine große Menge möglicher Himmelsbilder. Man braucht also Vorwissen, um die plausibleren Bilder von weniger plausiblen zu unterscheiden. So sind wir zum Beispiel sicher, dass die Helligkeit des Himmels niemals negativ sein kann. Mögliche Himmelsbilder, bei denen das an irgendeiner Stelle der Fall ist, können wir also ausschließen. Dann grenzen wir die Menge plausibler Bilder weiter ein: Wir wissen, dass es relativ dünn gesäte Objekte geben muss, die uns punktförmig erscheinen – die Sterne. Vielleicht kennen wir noch diffuse Strukturen wie das Band der Milchstraße. All diese Informationen lassen sich mit statistischen Mitteln beschreiben. In einer diffusen Struktur haben benachbarte Punkte beispielsweise eine ähnliche Helligkeit. Das kann man durch eine gegenseitige Abhängigkeit, eine Korrelation, ausdrücken. Wenn ich das für alle Paare von Himmelspunkten mache, habe ich plötzlich sehr viele Informationen, die ich berücksichtigen kann. Zwar sagt mir das nicht, was genau die Helligkeitswerte an jedem Punkt am Himmel sind. Aber dank der Wahrscheinlichkeiten weiß ich nun, welche Werte plausibel sind und welche nicht.

Ist das eine Form von maschinellem Lernen?

Absolut. Wir bauen generative Modelle, die eine große Zahl möglicher Himmelsbilder erzeugen. Konfrontiere ich diese mit echten Beobachtungsdaten, so kann ich mithilfe der Wahrscheinlichkeitstheorie die mit diesen Beobachtungen konsistenten Himmelsbilder finden. Der resultierende Algorithmus muss nicht darauf trainiert werden, welche Lösungen plausibel sind und welche nicht, denn dieses Wissen geben wir vor. Wir kennen also die von dem Algorithmus genutzten Informationen sehr genau, und deshalb handelt es sich bei ihm auch nicht um eine Blackbox! Welche Informationen wir benutzen und einbauen, liegt bei uns.

Wie läuft es konkret ab, wenn man mit dieser Methode ein Problem bearbeiten möchte?

Große Probleme wie zum Beispiel die dreidimensionale Rekonstruktion des Staubs in der Milchstraße lösen wir auf Supercomputern. Wenn Sie ein kleineres Problem haben, können Sie die Rekonstruktion auf Ihrem Laptop mit der frei verfügbaren Software NIFTy machen: zum Beispiel von einem einfachen Laborversuch, bei dem die Temperatur eines Objekts zu verschiedenen Zeitpunkten gemessen wird. Das Ergebnis ist eine eindimensionale Kurve, bei der die Messwerte schwanken und unvollständig sind. Mit der Informationsfeldtheorie bekommt man dann Temperaturwerte für die Zeiten, zu denen man nicht gemessen hat. Wenn Sie etwas darüber wissen, wie benachbarte Punkte, also Temperaturen, theoretisch korreliert sein müssten, dann sagen Sie das dem Algorithmus. Oder Sie sagen dem Algorithmus: Ich weiß fast nichts über die Korrelationsstruktur der Temperatur, lerne das bitte selbst.

Sie haben die Informationsfeldtheorie auf ein astronomisches Phänomen angewandt und das Bild des Schwarzen Lochs M87* nochmal neu rekonstruiert. Wie kam es dazu?

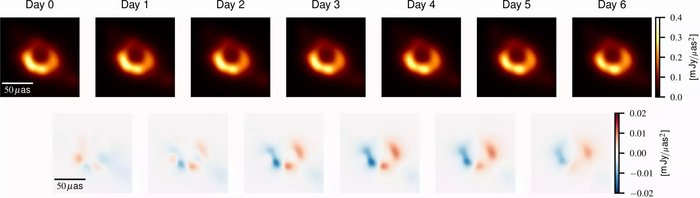

M87* ist ein aktives Schwarzes Loch im Zentrum des Virgo-Galaxienhaufens. Das Schwarze Loch selbst kann man nicht abbilden, dafür aber die charakteristischen Strukturen drumherum, wie etwa die stark strahlende Materie, die um das Schwarze Loch rotiert. Eine Kollaboration hat diese mit einem weltumspannenden Zusammenschluss von Teleskopen vermessen – dem Event Horizon Telescope, kurz EHT. Daraus resultierte das erste Bild vom Schatten eines Schwarzen Lochs, das im Jahr 2019 um die Welt ging und für viele Schlagzeilen sorgte. Die Rekonstruktion des Bildes war sehr aufwendig. Die Messtechnik beruht auf der Überlagerung von Radiostrahlung zwischen verschiedenen Teleskopen. Jede Antennenkombination erfasst dann nur einen kleinen Teil der Information, die man eigentlich für ein vollständiges Bild bräuchte – der Rest fehlt. Das hatte die EHT-Kollaboration damals mit eigenen Algorithmen gelöst. Eigentlich ist es aber genau die Art von Problem, die wir mit der Informationsfeldtheorie lösen können. Deswegen haben wir das Bild mit unserer Methode nochmal neu rekonstruiert.

Was ist dabei herausgekommen?

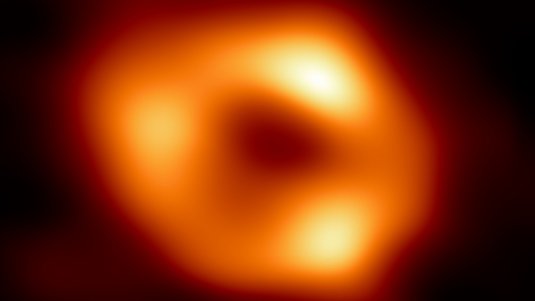

Wir konnten die Ergebnisse der EHT-Kollaboration bestätigen, unsere Rekonstruktion beinhaltet aber weniger Artefakte. Das Besondere war außerdem, dass wir auch die Zeit aufgelöst haben. Wir konnten erstmals einen kleinen Film erstellen, der die Bewegung des Rings während der sieben Tage dauernden Beobachtung zeigt. Vor kurzem hat ein Teil der beteiligten Forschungsgruppe übrigens auch das Bild vom Schwarzen Loch im Zentrum der Milchstraße, Sagittarius A*, noch einmal neu rekonstruiert – ebenfalls als Film.

Was haben Sie als nächstes vor?

Die Informationsfeldtheorie ist allgemein angelegt und lässt sich für verschiedenste Problemstellungen nutzen. Meine Gruppe hat die Informationsfeldtheorie nicht nur auf astronomische und kosmologische Datensätze angewendet, sondern unter anderem auch in der Biophysik. Dazu müssen wir die Theorie aber etwas an das jeweilige Problem anpassen, denn der Algorithmus braucht genaue Informationen über das genutzte Messverfahren. Im Rahmen des ErUM-IFT-Forschungsprojekts wollen wir beispielhaft Probleme bei der Bildgebung für einige Großforschungsanlagen lösen – zum Beispiel für Radioteleskope wie LOFAR in Europa und MeerKAT in Südafrika, aber auch für Anlagen, die kosmische Teilchenstrahlung vermessen, wie das Pierre-Auger-Observatorium in Argentinien. Aber auch die medizinische Bildgebung könnte von unserem Ansatz profitieren. Wir möchten, dass die Informationsfeldtheorie überall da eingesetzt wird, wo sie hilft.

Das Bundesministerium für Bildung und Forschung fördert das Projekt „ErUM-IFT: Informationsfeldtheorie für Experimente an Großforschungsanlagen“ im Zeitraum von März 2023 bis Februar 2026 mit rund 1 700 000 Euro.

Fördersumme: 1 690 747 Euro

Förderzeitraum: 01.03.2023 bis 28.02.2026

Förderkennzeichen: 05D23EO1, 05D23GU2, 05D23PA1, 05D23PB1, 05D23VK3, 05D23WE2, 05D23WN1, 05D23WO3

Beteiligte Institutionen: Max-Planck-Gesellschaft, Universität Hamburg, Technische Hochschule Aachen, Universität Bielefeld, Karlsruher Institut für Technologie, Universität Erlangen-Nürnberg, Bundeswehr Universität München, Technische Universität München

Quelle: https://www.weltderphysik.de/thema/bmbf/digitalisierung-in-der-grundlagenforschung/maschinelles-lernen-informationsfeldtheorie-dort-einsetzen-wo-sie-hilft/