Nobelpreis für Physik 2024

Dirk Eidemüller

Niklas Elmehed © Nobel Prize Outreach

Der Nobelpreis für Physik geht in diesem Jahr an John Hopfield von der Princeton University in den USA und an Geoffrey Hinton von der University of Toronto in Kanada. Sie werden für grundlegende Entdeckungen und Erfindungen geehrt, die maschinelles Lernen mit künstlichen neuronalen Netzen ermöglichen.

Ob als Sprachmodell wie ChatGPT, als Übersetzungssoftware oder für medizinische Diagnostik: Künstliche Intelligenz, kurz KI, revolutioniert derzeit geradezu die Informationstechnologie – und unseren Alltag. KI-Programme liefern aber nur dann sinnvolle Ergebnisse, wenn sie vorher auf vernünftige Weise mit guten Trainingsdaten auf ihren Einsatz vorbereitet wurden.

Nun ehrt das Nobelpreiskomitee die grundlegenden Forschungsarbeiten auf diesem Gebiet von John Hopfield und Geoffrey Hinton mit dem diesjährigen Nobelpreis für Physik. Die beiden Wissenschaftler arbeiteten schon seit den 1980er-Jahren an diesem damals noch jungen Thema. Zwar hatte es schon seit den 1940er-Jahren Ansätze zum maschinellen Lernen gegeben. Aber erst mit zunehmender Rechenleistung und Speicherkapazität der Computer war es überhaupt möglich, größere Datenmengen zum Training einzusetzen.

Nervenzellen als Vorbild

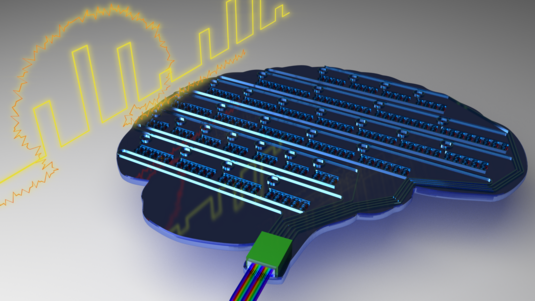

Klassische Computertechnik ist durch striktes Abarbeiten von Befehlen gekennzeichnet – vorgegeben durch den Programmiercode. Künstliche Intelligenz folgt hingegen einem anderen Ansatz. Sie nimmt sich Gehirnzellen und deren Verschaltung zum Vorbild. Wenn wir etwas lernen, arbeiten die in verschiedenen Schichten angeordneten Nervenzellen, Neuronen genannt, im Gehirn und zentralen Nervensystem parallel. Dabei sind die Neuronen der verschiedenen Schichten miteinander verbunden. Beim Lernen gewinnen bestimmte Verbindungen einen stärkeren Einfluss, während andere abgeschwächt werden. Dadurch bilden sich Verbindungsstrukturen, in denen die gelernte Information gespeichert ist.

Genauso läuft auch maschinelles Lernen ab: Zunächst erstellen Programmiererinnen und Programmierer eine Verschaltungsstruktur aus künstlichen Neuronen. Das sind Knoten, an denen Daten aus verschiedenen Verbindungen zusammengeführt werden. Dann „lernt“ diese Struktur anhand von Beispieldaten. Anfangs gibt das System noch schlechte Antworten. Aber im Lauf der Zeit passen Lernalgorithmen die Verbindungen zwischen den verschiedenen künstlichen Neuronen möglichst geschickt an, bis die Ergebnisse des Systems immer besser werden.

Training für echte Daten

Hierzu erarbeiteten die beiden Laureaten neue Ideen, die das Gebiet bis heute befruchten. John Hopfield von der Universität Princeton hatte bereits früher auf den Gebieten Magnetismus und Molekularbiologie geforscht und sich einen Ruf als herausragender Theoretiker erworben. Bei einem Treffen zu Neurowissenschaften wurde er auf die Hirnforschung aufmerksam und schlug im Jahr 1982 eine Methode vor, wie künstliche neuronale Netzwerke eine Art assoziatives Gedächtnis entwickeln können.

Dabei wählte er ein Prinzip, das von einer sogenannten Potenziallandschaft inspiriert ist. Man kann sie sich wie eine Gebirgslandschaft vorstellen, in der eine Kugel stets den direkten Weg nach unten sucht – zu einem möglichst energiearmen Zustand.

Auf das maschinelle Lernen übersetzt heißt das: Wenn ein Pixel eines Trainingsbildes zu einem bereits gespeicherten Bild passt, dann wird die Energie des entsprechenden Knotens und Netzwerkpfades abgesenkt. Passt das Trainingsbild nicht, geht die Suche weiter. Auf diese Weise bildet sich nach erfolgreichem Training sozusagen eine Landschaft aus, die künftigen Daten den richtigen Weg zum Ziel weist. Diese Struktur wird ihm zu Ehren „Hopfield-Netzwerk“ genannt. Damit lassen sich etwa Bilder speichern, ohne jeden Bildpunkt einzeln zu speichern, und sogar Bilder voneinander unterscheiden.

Mit erweiterten Netzwerken Muster erkennen

In den folgenden Jahren arbeitete Geoffrey Hinton von der Universität Toronto dann mit solchen Hopfield-Netzwerken und entwickelte sie weiter. Insbesondere schuf er eine sogenannte Boltzmann-Maschine, die sich von Hopfields ursprünglichem Ansatz unterschied. Das Ziel von Hinton war es, Daten nicht nur zu speichern und bereits bekannten Daten zuzuordnen. Er wollte sehen, ob sich mit solchen Netzwerken auch Informationen strukturieren lassen, um Muster zu erkennen.

Hierzu nutzte Hinton Methoden der statistischen Physik – insbesondere eine Gleichung von Ludwig Boltzmann, der im 19. Jahrhundert die Grundlagen der Thermodynamik mitgeschaffen hatte. Nach dieser Gleichung sind je nach Energieniveau manche Zustände wahrscheinlicher als andere. Nach diesem Prinzip schuf Hinton ein Netzwerksystem aus mehreren Schichten und zwei verschiedenen Typen von Knoten – „sichtbare“ und „versteckte“. Die sichtbaren Knoten bringen Information von außen in das Netzwerk und tragen die verarbeitete Information wieder nach außen. Die versteckten Knoten verarbeiten innerhalb des Systems die Informationen.

Mit dieser Struktur hatte Hinton bereits ein sogenanntes „generatives Modell“ geschaffen. Wie auch heutige Systeme kann es Muster nicht nur erkennen, sondern auch neue Daten anhand bekannter Muster erzeugen. Eine Boltzmann-Maschine kann etwa bestimmte Motive auf Bildern erkennen – auch wenn sie das spezielle Bild noch nicht kennt. Damit ist sie ein entscheidender Vorläufer gegenwärtiger KI-Systeme. In abgewandelter Form wird sie immer noch eingesetzt – etwa wenn Online-Shops anhand unserer Kaufgewohnheiten neue Produkte empfehlen.

Die ursprüngliche Boltzmann-Maschine eignete sich jedoch kaum, um komplexere Aufgaben zu erledigen. Während viele das Interesse an dem gesamten Gebiet verloren hatten, verfolgte Hinton es weiter und stellte 2006 gemeinsam mit Kolleginnen und Kollegen eine Reihe neuer Ideen vor. Dazu zählten vortrainierte Netzwerke mit einer ganzen Reihe von Boltzmann-Maschinen, die in verschiedenen Ebenen übereinander angeordnet waren. Das erhöhte die Trainingseffizienz und Leistungsfähigkeit des gesamten Systems enorm. Die heutigen, komplexen KI-Systeme sind meist sogenannte „tiefe neuronale Netzwerke“, die aus vielen Schichten von künstlichen Neuronen bestehen.

Von der Grundlagenforschung zur IT-Revolution

Im Anschluss an die Nobelpreisverkündung zeigte sich Hinton im Telefonat geradezu überwältigt von der Ehrung. In der Tat sind maschinelles Lernen und Künstliche Intelligenz Gebiete, die nicht zu den klassischen Kerndisziplinen der Physik gehören, sondern mittlerweile eher der Informatik zugerechnet werden. Ihr Ursprung liegt aber durchaus in der Physik, beziehungsweise in den Physikinstituten, die die Entwicklung der Computertechnik und Software vorangetrieben haben. Heute arbeiten Forschende aus Physik, Informatik und Mathematik oft gemeinsam daran, diese Technologien weiterzuentwickeln.

Über viele Jahre waren es besonders die großen Forschungseinrichtungen in der Physik, in denen maschinelles Lernen zum Einsatz kam. Denn von der Teilchen- bis zur Astrophysik fallen in der Forschung Unmengen an Daten an, die es zu verarbeiten und auszuwerten gilt. Dabei entwickelten die Forschenden Methoden, dank derer dieses Gebiet im letzten Jahrzehnt rapide gewachsen ist. Mit der jetzigen Ehrung zeigt sich einmal mehr, wie stark sich jahrzehntelange Grundlagenforschung auf die moderne Gesellschaft auswirken kann.

Quelle: https://www.weltderphysik.de/thema/nobelpreis/nobelpreis-fuer-physik-2024/